La deduplicación de datos es un proceso crucial en la gestión de datos que implica identificar y eliminar registros duplicados dentro de un conjunto de datos. Esta práctica mejora la calidad de los datos, reduce los costos de almacenamiento y mejora la eficiencia del procesamiento de datos.

La experiencia es fundamental en la gestión de datos, y Match Data Pro aporta años de experiencia. Nuestro equipo de especialistas en datos comprende a la perfección los desafíos que enfrentan las organizaciones que gestionan grandes cantidades de datos de múltiples fuentes. A lo largo de los años, hemos perfeccionado nuestros procesos, desarrollado herramientas robustas y construido un legado de resultados confiables para nuestros clientes.

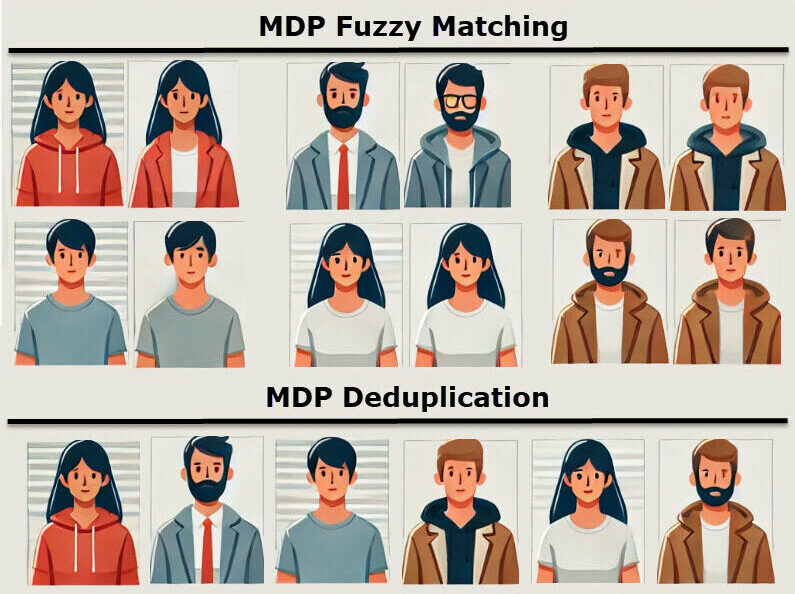

The two main types are file-level and block-level deduplication. File-level finds and removes identical files, while block-level goes deeper—identifying duplicate segments inside different files. Match Data Pro uses both concepts conceptually through advanced record-level matching, ensuring duplicate records are eliminated with precision, even when formats or spellings differ.

Real-world data is messy. Fuzzy matching removes near-duplicates and reconciles inconsistencies so analytics, marketing, and reporting are trustworthy. In Match Data Pro, fuzzy matching plus cleansing produces clean, unified datasets that reduce errors and wasted spend.

The main risks come from over-aggressive matching—when valid records are mistakenly merged. Match Data Pro avoids this with configurable thresholds and AI-assisted fuzzy matching, giving you full control and review before any merge occurs.

Traditionally, deduplication required scripts or manual cleanup. With Match Data Pro, it’s point-and-click simple: import your data, define your match rules (exact or fuzzy), review duplicates, and merge with confidence—all inside an intuitive web interface.

Normalization standardizes data (like formatting phone numbers or addresses), while deduplication removes repeated or overlapping entries. In Match Data Pro, these steps work together—normalize first, deduplicate second—for higher match accuracy and cleaner results.

It depends on your dataset, but typical results range from 5% to 25% duplicate reduction. Match Data Pro’s profiling module helps estimate your duplication rate before running a full cleanup, so you can measure improvement precisely.

Excel offers basic duplicate removal, but it can’t detect near-duplicates like “Jon Smith” vs “John Smyth.” Match Data Pro goes beyond exact matches—using fuzzy algorithms and data profiling to find duplicates that spreadsheets miss.

Common challenges include inconsistent formats, typos, missing fields, and cross-source duplicates. Match Data Pro solves these through intelligent preprocessing—profiling, standardization, and configurable fuzzy matching to ensure accuracy at scale.

Any structured data: contacts, leads, vendors, customers, or products. Match Data Pro supports multiple file formats (CSV, Excel, Parquet, databases, APIs) and handles deduplication across data sources and systems in one workflow.

Yes. Deduplication is critical for maintaining data integrity in databases. Match Data Pro integrates with database exports or APIs to detect duplicates before they enter production, saving storage and keeping queries accurate.

En Match Data Pro, nuestro enfoque principal es la coincidencia de datos difusos y la resolución de entidades, pero nuestra plataforma va mucho más allá de eso.

Copyright 2026 Match Data Pro. All Rights Reserved